데이터 과학에서 모델의 성능을 제대로 평가하는 건 정말 중요해요.

우리가 만든 모델이 얼마나 잘 작동하는지, 어떤 부분을 개선해야 하는지 알려주는 중요한 지표들이 있거든요. 특히 분류 모델의 경우, 정확도만으로는 부족할 때가 많아서 다양한 평가 지표를 활용해야 해요. 오늘은 분류 모델 평가 지표에 대해 속속들이 파헤쳐 보는 시간을 가져볼게요!

혼동 행렬 (Confusion Matrix): 모델의 예측 결과 한눈에 파악하기

혼동 행렬은 모델의 예측 결과를 한눈에 보여주는 아주 유용한 도구에요.

모델이 어떤 부분에서 헷갈려하는지, 어떤 유형의 오류를 자주 범하는지 등을 파악하는 데 도움을 줘요. 마치 모델의 성적표와 같은 거라고 생각하면 쉬워요.

혼동 행렬의 구성 요소

혼동 행렬은 True Positive(TP), True Negative(TN), False Positive(FP), False Negative(FN) 이렇게 네 가지 요소로 구성되어 있어요.

- TP (True Positive): 실제 Positive인 경우를 Positive로 예측한 거예요.

- 예를 들어, 스팸 메일 분류 모델에서 실제 스팸 메일을 스팸으로 정확하게 분류한 경우가 되겠죠.

- TN (True Negative): 실제 Negative인 경우를 Negative로 예측한 거예요.

- 같은 스팸 메일 모델에서 실제 일반 메일을 일반 메일로 정확하게 분류한 경우라고 할 수 있죠.

- FP (False Positive): 실제 Negative인 경우를 Positive로 잘못 예측한 거예요.

- 스팸 메일 모델에서 실제 일반 메일을 스팸으로 잘못 분류한 경우가 되겠네요. 이 경우, 우리는 '오경보'라고 부르기도 해요.

- FN (False Negative): 실제 Positive인 경우를 Negative로 잘못 예측한 거예요.

- 스팸 메일 모델에서 실제 스팸 메일을 일반 메일로 잘못 분류한 경우죠. 이런 오류는 놓치는 경우가 발생할 수 있어서 위험할 수 있어요.

혼동 행렬의 활용

혼동 행렬을 통해 모델의 성능을 종합적으로 판단할 수 있어요.

예를 들어, FP가 많이 발생한다면 모델이 오경보를 자주 발생시키는 경향이 있다는 것을 알 수 있고, FN이 많다면 실제 Positive인 경우를 놓치는 경우가 많다는 것을 알 수 있죠.

이런 정보들을 바탕으로 모델을 개선해 나갈 수 있어요.

정확도 (Accuracy): 전체 예측 중 정답 비율

정확도는 전체 예측 중에서 몇 개를 정확하게 맞혔는지를 나타내는 가장 기본적인 지표에요.

모델이 얼마나 정확한지 빠르게 확인하고 싶을 때 유용하죠.

정확도 계산 공식

정확도는 다음과 같은 공식으로 계산해요.

$$

Accuracy = \frac{TP + TN}{TP + TN + FP + FN}

$$

정확도의 한계

정확도는 간편하지만, 데이터가 불균형할 경우 모델의 성능을 제대로 반영하지 못할 수 있다는 단점이 있어요.

예를 들어, 90%의 데이터가 Negative이고 10%의 데이터가 Positive인 데이터셋에서 모델이 모든 데이터를 Negative로 예측한다고 가정해 볼게요. 그럼 정확도는 90%가 나오겠죠. 하지만 실제로는 Positive인 경우를 하나도 맞히지 못한 거예요. 이처럼 데이터가 불균형할 때는 정확도만으로는 모델의 성능을 판단하기 어려워요.

정밀도 (Precision): Positive 예측 중 실제 Positive 비율

정밀도는 모델이 Positive라고 예측한 것들 중에서 실제로 Positive인 비율을 나타내는 지표에요.

FP를 줄이는 데 초점을 맞추는 지표라고 생각하면 돼요.

정밀도 계산 공식

정밀도는 다음과 같은 공식으로 계산해요.

$$

Precision = \frac{TP}{TP + FP}

$$

정밀도의 활용

정밀도는 실제 Negative인 데이터를 Positive로 잘못 예측하는 것을 최소화해야 하는 경우에 유용해요.

예를 들어, 질병 진단 모델에서 건강한 사람을 잘못해서 환자라고 판단하는 경우를 최소화해야 할 때, 정밀도를 중요하게 고려해야 해요.

재현율 (Recall): 실제 Positive 중 모델이 Positive로 예측한 비율

재현율은 실제 Positive인 것들 중에서 모델이 몇 개를 찾아냈는지를 나타내는 지표에요.

FN을 줄이는 데 초점을 맞추는 지표라고 생각하면 돼요.

재현율 계산 공식

재현율은 다음과 같은 공식으로 계산해요.

$$

Recall = \frac{TP}{TP + FN}

$$

재현율의 활용

재현율은 실제 Positive인 데이터를 Negative로 잘못 예측하는 것을 최소화해야 하는 경우에 유용해요.

예금 사기 탐지 모델에서 실제 사기 행위를 놓치는 경우를 최소화해야 할 때, 재현율을 중요하게 고려해야 해요.

F1 점수 (F1 Score): 정밀도와 재현율의 조화 평균

F1 점수는 정밀도와 재현율의 조화 평균으로, 두 지표의 균형을 맞추는 데 유용한 지표에요.

정밀도와 재현율이 모두 중요할 때 사용하면 좋아요.

F1 점수 계산 공식

F1 점수는 다음과 같은 공식으로 계산해요.

$$

F1 = \frac{2 \times Precision \times Recall}{Precision + Recall}

$$

F1 점수의 활용

F1 점수는 정밀도와 재현율을 동시에 고려해야 하는 경우에 유용해요.

예를 들어, 고객 이탈 예측 모델에서 이탈 고객을 정확하게 예측하면서 동시에 이탈 고객을 놓치지 않도록 해야 할 때 F1 점수를 사용하면 좋아요.

AUC-ROC 곡선: 다양한 임계값에서 모델 성능 평가

AUC-ROC 곡선은 다양한 임계값에서 모델의 성능을 평가하는 도구에요.

모델이 얼마나 잘 클래스를 구분하는지, 즉 클래스 간 구별 능력이 뛰어난지를 나타내는 지표죠.

AUC-ROC 곡선 이해하기

AUC-ROC 곡선은 True Positive Rate(TPR)과 False Positive Rate(FPR)을 이용해서 그려요.

TPR은 실제 Positive 중에서 모델이 Positive로 예측한 비율이고, FPR은 실제 Negative 중에서 모델이 Positive로 예측한 비율이에요.

AUC 값은 ROC 곡선 아래 면적을 나타내는데, AUC 값이 클수록 클래스 간 구별 능력이 뛰어나다고 해석할 수 있어요.

AUC-ROC 곡선의 활용

AUC-ROC 곡선은 모델의 성능을 다양한 관점에서 평가하고 싶을 때 유용해요.

특히 클래스 간 불균형이 심한 경우, 정확도, 정밀도, 재현율만으로는 모델의 성능을 제대로 판단하기 어려울 때 AUC-ROC 곡선을 활용하면 좋아요.

모델 평가 지표 선택: 상황에 맞게 지표 활용하기

모델 평가 시 상황에 맞는 지표를 선택하는 것이 중요해요.

어떤 지표가 가장 중요한지는 문제의 특성과 목적에 따라 달라지거든요.

지표 선택 기준

- 데이터 불균형: 데이터가 불균형하다면 정확도보다는 정밀도, 재현율, F1 점수, AUC-ROC 곡선을 고려해야 해요.

- 오류 유형: FP를 줄여야 한다면 정밀도를, FN을 줄여야 한다면 재현율을 중시해야 해요.

- 모델 목표: 모델의 목표에 따라 중요한 지표가 달라져요. 예를 들어, 스팸 필터 모델에서는 FP를 줄이는 것이 중요할 수 있고, 암 진단 모델에서는 FN을 줄이는 것이 중요할 수 있어요.

다양한 지표 활용

보통 하나의 지표만 사용하기보다는 여러 지표를 함께 활용하여 모델의 성능을 종합적으로 판단하는 것이 좋아요.

각 지표가 나타내는 의미를 잘 이해하고, 문제 상황에 맞게 지표를 선택하고 해석하는 연습을 꾸준히 해야 해요.

실전 예시: 타이타닉 생존 예측 모델 평가

타이타닉 생존 예측 모델을 예시로 들어, 모델 평가 지표를 어떻게 활용하는지 살펴볼게요.

데이터셋 및 모델

타이타닉 데이터셋은 1912년 타이타닉 호 침몰 사건 당시 승객들의 정보와 생존 여부를 담고 있어요.

우리는 이 데이터셋을 이용하여 승객의 생존 여부를 예측하는 분류 모델을 만들 수 있고, 모델의 성능을 평가할 수 있죠.

성능 평가

만약 타이타닉 생존 예측 모델에서 FN을 줄이는 것이 중요하다면(즉, 실제 생존자를 사망자로 잘못 예측하는 것을 최소화해야 한다면) 재현율을 중요하게 고려해야 해요.

반대로, FP를 줄이는 것이 중요하다면(즉, 실제 사망자를 생존자로 잘못 예측하는 것을 최소화해야 한다면) 정밀도를 중요하게 고려해야 해요.

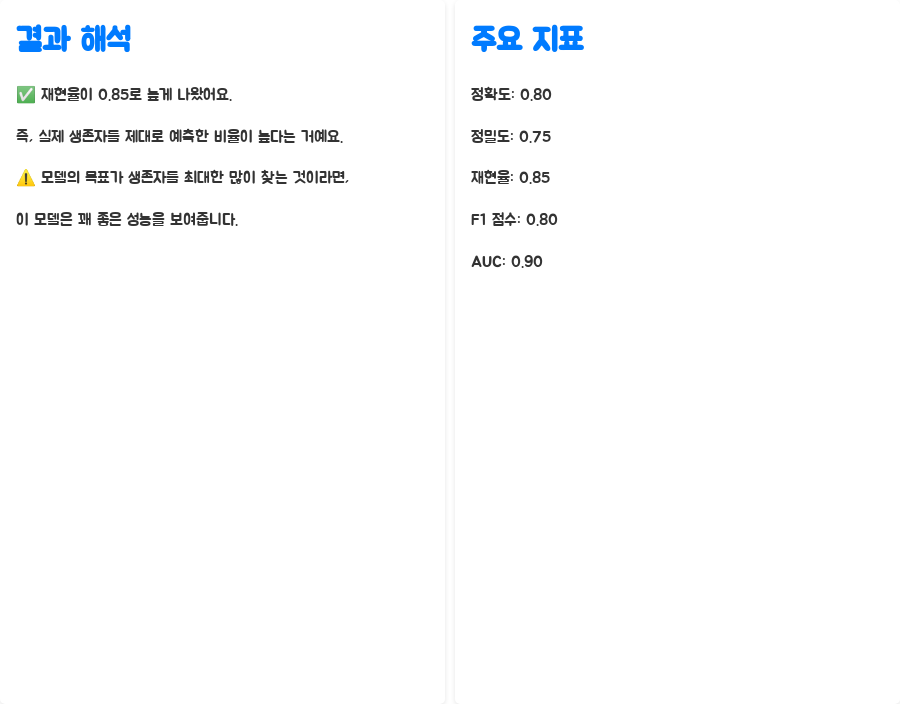

결과 해석

| 정확도 | 0.80 |

| 정밀도 | 0.75 |

| 재현율 | 0.85 |

| F1 점수 | 0.80 |

| AUC | 0.90 |

지표 값

이 표에서 재현율이 0.85로 높게 나온 것을 확인할 수 있어요. 즉, 실제 생존자를 제대로 예측한 비율이 높다는 거죠.

만약 모델의 목표가 생존자를 최대한 많이 찾아내는 것이었다면, 이 모델은 꽤 좋은 성능을 보여주는 거예요.

마무리: 분류 모델 평가 지표, 꾸준히 학습하고 활용하기

오늘은 분류 모델 평가 지표에 대해 자세히 알아봤어요.

정확도, 정밀도, 재현율, F1 점수, AUC-ROC 곡선 등 다양한 지표가 있고, 각 지표는 모델의 다른 측면을 보여주기 때문에 상황에 맞게 적절한 지표를 선택하는 것이 중요해요.

모델의 성능을 제대로 평가하고 개선하기 위해서는 이러한 지표들을 꾸준히 학습하고, 실제 모델에 적용해 보면서 경험을 쌓는 것이 중요해요.

앞으로도 다양한 모델 평가 방법과 실습 예제를 통해 모델 성능 향상에 도움이 되는 정보들을 공유할게요!

궁금한 점이 있으신가요?

Q1. 혼동 행렬이 왜 중요한가요?

A1. 혼동 행렬은 모델이 어떤 유형의 오류를 범하는지 한눈에 보여주기 때문에, 모델의 성능을 개선하는 데 매우 중요해요.

어떤 유형의 오류가 더 심각한지 파악하고, 그에 맞춰 모델을 개선할 수 있도록 도와주죠.

Q2. 데이터 불균형이 모델 평가에 어떤 영향을 미치나요?

A2. 데이터가 불균형하면 정확도가 모델의 성능을 제대로 반영하지 못할 수 있어요.

예를 들어, Negative 데이터가 압도적으로 많을 경우, 모델이 모든 데이터를 Negative로 예측하더라도 정확도는 높게 나올 수 있거든요.

따라서 데이터 불균형 상황에서는 정밀도, 재현율, F1 점수, AUC-ROC 곡선 등 다른 지표들을 함께 고려해야 해요.

Q3. F1 점수는 언제 사용하는 게 좋나요?

A3. 정밀도와 재현율이 모두 중요할 때 F1 점수를 사용하는 게 좋아요.

두 지표의 균형을 맞추어 모델의 성능을 평가하고 싶을 때 유용하죠.

예를 들어, 스팸 필터 모델에서 스팸 메일을 최대한 많이 걸러내면서(높은 재현율) 동시에 일반 메일을 스팸으로 잘못 분류하는 오류(높은 정밀도)를 최소화해야 할 때, F1 점수를 사용하면 좋아요.

키워드:데이터과학,머신러닝,분류모델,모델평가,혼동행렬,정확도,정밀도,재현율,F1스코어,AUCROC,성능지표,머신러닝모델,데이터분석,AI,인공지능,데이터사이언스,kaggle,타이타닉,예측모델,classification,model_evaluation,machinelearning,datascience,AI모델,딥러닝,딥러닝모델,데이터마이닝,데이터분석,데이터과학자,데이터사이언티스트,데이터분석가,데이터전처리