데이터 과학에서 텍스트 분류는 엄청나게 중요한 부분이에요. 스팸 메일을 걸러내거나 뉴스 기사를 분류하거나, 아니면 고객 리뷰의 감정을 분석하는 것처럼 말이죠. 이런 다양한 텍스트 분류 작업에서 나이브 베이즈 분류 알고리즘은 꽤 유용하게 쓰이는데요, 오늘은 이 나이브 베이즈 분류 알고리즘에 대해서 좀 더 자세히 파헤쳐 보려고 해요!

나이브 베이즈 분류 알고리즘: 베이즈 정리와의 만남

나이브 베이즈 분류 알고리즘은 이름처럼 꽤나 직관적인 알고리즘이에요. 베이즈 정리를 기반으로 만들어졌는데, 이 베이즈 정리는 어떤 사건이 일어났을 때 다른 사건이 일어날 확률을 계산하는 데 엄청 유용하거든요.

예를 들어, 어떤 이메일을 받았을 때 이 이메일이 스팸일 확률을 계산하고 싶다고 해봐요. 이때 베이즈 정리를 사용하면 이 이메일의 내용(단어들)이 스팸일 확률을 계산할 수 있어요. 즉, 이메일에 특정 단어가 포함되어 있을 때, 그 이메일이 스팸일 확률을 계산하는 거죠.

베이즈 정리: 나이브 베이즈의 핵심

베이즈 정리는 다음과 같은 수식으로 표현돼요.

$$P(A|B) = \frac{P(B|A)P(A)}{P(B)}$$

여기서 $P(A|B)$는 B가 일어났을 때 A가 일어날 확률(사후 확률)이고, $P(B|A)$는 A가 일어났을 때 B가 일어날 확률(가능도), $P(A)$는 A가 일어날 확률(사전 확률), $P(B)$는 B가 일어날 확률(증거)이에요.

나이브 베이즈 분류 알고리즘은 이 베이즈 정리를 이용해서 텍스트를 분류하는데요, 텍스트를 구성하는 단어들이 서로 독립적이라고 가정하는 게 특징이에요. 즉, 어떤 단어가 다른 단어와 관계없이 독립적으로 나타난다고 생각하는 거죠. 이 때문에 '나이브'(naive, 순진한)라는 이름이 붙었어요.

나이브 베이즈 분류 알고리즘의 동작 원리

나이브 베이즈 분류 알고리즘은 훈련 데이터를 이용해서 각 단어가 특정 클래스(예를 들어, 스팸 또는 정상 메일)에 속할 확률을 계산해요. 그리고 새로운 텍스트가 들어오면, 그 텍스트에 포함된 단어들의 확률을 이용해서 해당 텍스트가 어떤 클래스에 속할지 예측하는 거죠.

음… 좀 더 쉽게 설명해 볼게요.

만약 스팸 메일 필터를 만든다고 생각해 봐요. 훈련 데이터에는 스팸 메일과 정상 메일이 섞여 있고, 각 메일에 어떤 단어들이 얼마나 자주 등장하는지 기록되어 있어요. 예를 들어, "무료", "당첨", "수익" 같은 단어는 스팸 메일에 자주 등장하고, "회의", "보고서", "업무" 같은 단어는 정상 메일에 자주 등장한다고 가정해 볼 수 있겠죠.

이제 새로운 이메일이 들어왔어요. 이 이메일에는 "무료", "수익"이라는 단어가 포함되어 있네요. 나이브 베이즈 분류 알고리즘은 훈련 데이터를 바탕으로 "무료", "수익"이라는 단어가 스팸 메일에 자주 등장한다는 것을 알고 있으니까, 이 이메일이 스팸 메일일 확률이 높다고 판단하는 거예요.

나이브 베이즈 분류 알고리즘의 장점과 단점

장점: 속도와 단순함의 조화

나이브 베이즈 분류 알고리즘은 몇 가지 장점을 가지고 있어요.

첫째, 학습 속도가 빠르고, 분류 속도도 빠르다 는 거예요. 훈련 데이터를 이용해서 각 단어의 확률을 계산하는 작업이 복잡하지 않기 때문에, 다른 알고리즘에 비해서 훨씬 빠르게 학습하고 분류할 수 있답니다.

둘째, 구현이 쉽고, 이해하기 쉽다 는 점도 장점이에요. 베이즈 정리를 기반으로 하고 있기 때문에, 알고리즘의 원리를 이해하기가 쉽고, 코드로 구현하기도 쉬워요.

셋째, 대용량 데이터에도 잘 적용된다 는 점도 큰 장점이에요. 텍스트 데이터는 엄청나게 많을 수 있는데, 나이브 베이즈 분류 알고리즘은 이런 대용량 데이터를 처리하는 데 효율적이에요.

단점: 독립성 가정의 한계

하지만 나이브 베이즈 분류 알고리즘은 몇 가지 단점도 가지고 있어요.

가장 큰 단점은 단어들 간의 독립성을 가정한다 는 거예요. 현실에서는 단어들이 서로 연관되어 있는 경우가 많아요. 예를 들어, "사랑"이라는 단어가 등장하면 "행복"이라는 단어가 함께 등장할 가능성이 높죠. 하지만 나이브 베이즈 분류 알고리즘은 이런 연관성을 무시하고 단어들을 독립적으로 취급하기 때문에, 정확도가 떨어질 수 있어요.

또 다른 단점은 특정한 경우에 잘 작동하지 않을 수 있다 는 거예요. 예를 들어, 모든 단어가 동일한 빈도로 나타나는 경우에는 나이브 베이즈 분류 알고리즘이 제대로 작동하지 않을 수 있어요.

나이브 베이즈 분류 알고리즘의 다양한 활용

나이브 베이즈 분류 알고리즘은 텍스트 분류 외에도 다양한 분야에서 활용될 수 있어요.

스팸 필터링

아까 예시로 들었던 것처럼, 나이브 베이즈 분류 알고리즘은 스팸 필터링에 널리 활용되고 있어요. 이메일의 내용을 분석하여 스팸 메일인지 아닌지를 판별하는 데 유용하죠.

감정 분석

소셜 미디어 게시물이나 상품 리뷰를 분석해서 긍정적인 감정인지, 부정적인 감정인지, 혹은 중립적인 감정인지 판별하는 감정 분석에도 나이브 베이즈 분류 알고리즘을 사용할 수 있어요.

텍스트 분류

뉴스 기사를 분류하거나, 고객 문의를 카테고리별로 분류하는 것처럼 텍스트를 다양한 카테고리로 분류하는 데에도 나이브 베이즈 분류 알고리즘이 사용될 수 있어요.

추천 시스템

고객의 과거 구매 이력이나 선호도를 분석하여, 고객에게 맞춤형 상품이나 서비스를 추천하는 추천 시스템에도 나이브 베이즈 분류 알고리즘이 활용될 수 있답니다.

나이브 베이즈 분류 알고리즘의 종류

나이브 베이즈 분류 알고리즘은 데이터의 특성에 따라 몇 가지 종류로 나뉘어요.

다항 분포 나이브 베이즈(Multinomial Naive Bayes)

텍스트 분류에 가장 많이 사용되는 유형이에요. 각 단어의 빈도수를 기반으로 확률을 계산해요.

베르누이 나이브 베이즈(Bernoulli Naive Bayes)

텍스트 분류에 사용되지만, 단어의 존재 유무만 고려하고 빈도수는 고려하지 않아요.

가우시안 나이브 베이즈(Gaussian Naive Bayes)

연속적인 값을 가진 데이터를 분류하는 데 사용돼요. 각 특성이 정규 분포를 따른다고 가정하고, 평균과 표준 편차를 이용해서 확률을 계산해요.

나이브 베이즈 분류 알고리즘의 개선

나이브 베이즈 분류 알고리즘의 단점을 보완하기 위해서 다양한 개선 방법들이 연구되고 있어요.

스무딩(Smoothing)

단어의 빈도수가 0인 경우에 발생하는 문제를 해결하기 위해 사용하는 기법이에요. 0이 아닌 작은 값으로 빈도수를 조정해서, 확률 계산 시 문제를 방지하는 거죠.

특징 선택(Feature Selection)

텍스트 데이터에서 중요한 특징만을 선택하여, 분류 성능을 향상시키는 기법이에요.

앙상블 기법(Ensemble Method)

여러 개의 나이브 베이즈 분류기를 결합하여, 분류 성능을 높이는 기법이에요.

나이브 베이즈 분류 알고리즘의 실제 적용 예시

스팸 메일 필터

대부분의 이메일 클라이언트에서 사용하는 스팸 필터는 나이브 베이즈 분류 알고리즘을 기반으로 만들어졌어요. 이메일의 제목과 내용에 포함된 단어들을 분석하여, 스팸 메일일 확률을 계산하고, 일정 확률을 넘으면 스팸 폴더로 이동시키는 거죠.

뉴스 기사 분류

온라인 뉴스 사이트에서 뉴스 기사를 카테고리별로 분류하는 데에도 나이브 베이즈 분류 알고리즘이 사용되고 있어요. 기사의 제목과 내용에 포함된 단어들을 분석하여, 스포츠, 정치, 경제 등의 카테고리로 분류하는 거죠.

고객 문의 분류

고객센터에서 고객들의 문의를 분류하는 데에도 나이브 베이즈 분류 알고리즘이 사용될 수 있어요. 고객의 질문 내용을 분석하여, 결제, 배송, 환불 등의 카테고리로 분류하고, 해당 카테고리에 맞는 상담원에게 연결해주는 거죠.

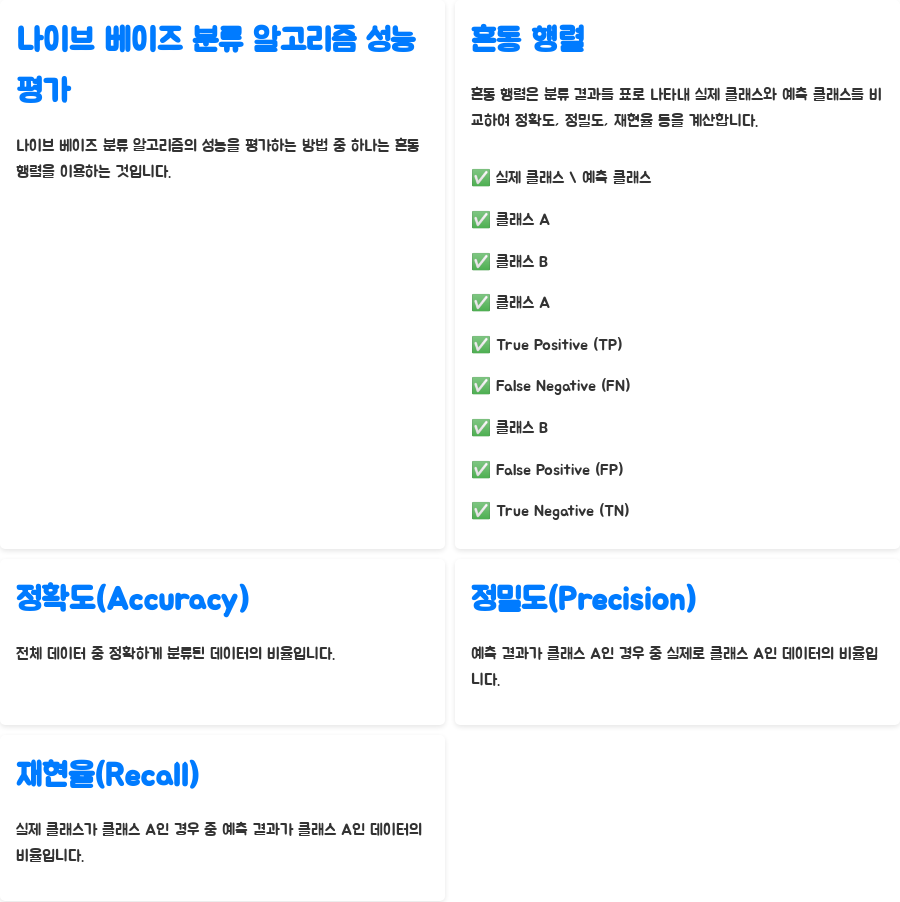

나이브 베이즈 분류 알고리즘 성능 평가

나이브 베이즈 분류 알고리즘의 성능을 평가하는 방법에는 여러 가지가 있지만, 대표적으로 혼동 행렬(Confusion Matrix)을 이용하는 방법이 있어요.

혼동 행렬은 분류 결과를 표로 나타낸 것인데요, 실제 클래스와 예측 클래스를 비교하여, 정확도(Accuracy), 정밀도(Precision), 재현율(Recall) 등을 계산할 수 있답니다.

| 클래스 A | True Positive (TP) | False Negative (FN) |

| 클래스 B | False Positive (FP) | True Negative (TN) |

실제 클래스 \ 예측 클래스 클래스 A 클래스 B

정확도(Accuracy)는 전체 데이터 중에서 정확하게 분류된 데이터의 비율이에요.

정밀도(Precision)는 예측 결과가 클래스 A인 경우 중에서 실제로 클래스 A인 데이터의 비율이에요.

재현율(Recall)는 실제 클래스가 클래스 A인 경우 중에서 예측 결과가 클래스 A인 데이터의 비율이에요.

자주 묻는 질문 (FAQ)

Q1. 나이브 베이즈 분류 알고리즘은 어떤 경우에 적합한가요?

A1. 나이브 베이즈 분류 알고리즘은 텍스트 분류, 스팸 필터링, 감정 분석 등과 같이 대용량의 텍스트 데이터를 빠르게 처리해야 하는 경우에 적합해요. 특히, 데이터의 특성이 서로 독립적이라고 가정할 수 있는 경우에 좋은 성능을 보여주죠.

Q2. 나이브 베이즈 분류 알고리즘의 단점은 무엇인가요?

A2. 나이브 베이즈 분류 알고리즘은 단어 간의 의존성을 고려하지 않는다는 단점이 있어요. 또한, 데이터의 특성이 서로 연관되어 있는 경우에는 성능이 저하될 수 있답니다.

Q3. 나이브 베이즈 분류 알고리즘의 성능을 향상시키려면 어떻게 해야 하나요?

A3. 나이브 베이즈 분류 알고리즘의 성능을 향상시키려면 스무딩 기법을 적용하거나, 특징 선택 기법을 사용, 혹은 앙상블 기법을 적용하는 방법이 있어요. 또한, 훈련 데이터의 품질을 향상시키는 것도 중요하답니다.

마무리

오늘은 나이브 베이즈 분류 알고리즘에 대해서 알아봤어요. 텍스트 분류 작업에 널리 사용되는 알고리즘이지만, 단점도 분명히 존재하기 때문에, 데이터의 특성과 목적에 맞게 적절하게 사용하는 것이 중요하답니다.

키워드

나이브베이즈,나이브베이즈분류,머신러닝,데이터과학,텍스트분류,알고리즘,베이즈정리,스팸필터,감정분석,추천시스템,데이터분석,인공지능,AI,ML,NLP,자연어처리,분류,예측,확률,독립성가정,스무딩,특징선택,앙상블,혼동행렬,정확도,정밀도,재현율,데이터마이닝,데이터사이언스,데이터분석,머신러닝알고리즘,머신러닝공부,머신러닝스터디,데이터과학자,데이터분석가,데이터사이언티스트,데이터분석전문가,IT,정보과학,컴퓨터과학,python,R